Obsidian + Smart Connection + Ollama:让本地私有大模型成为你的笔记智能体

- 作者

由于学校、公司或其他外部环境的限制,很多小伙伴无法使用诸如 OpenRouter、OpenAI 这样的外部闭源大模型。而最近也有不少人在留言中询问,如何在 Obsidian 的 Smart Connection 插件中使用自己搭建的 Ollama 模型。为了响应大家的需求,我们专门制作了这篇教程,教你如何在 Obsidian 的 Smart Connection 插件中无缝集成 Ollama 模型。希望这篇指南能为大家带来灵感和帮助,让你的笔记系统更加智能高效!

本地下载 Ollama 并运行模型

安装 Ollama

macOS

MacOS 下载 Ollama 链接 - https://ollama.com/download/Ollama-darwin.zip

Windows

Windows 下载 Ollama 链接 - https://ollama.com/download/OllamaSetup.exe

Linux

Linux 下载并安装 Ollama

curl -fsSL https://ollama.com/install.sh | sh

启动模型

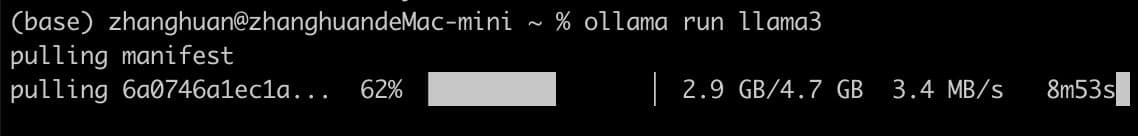

下面展示一下在 Mac 电脑里面通过 ollama 启动 llama3 模型,其他操作系统类似。

ollama run llama3

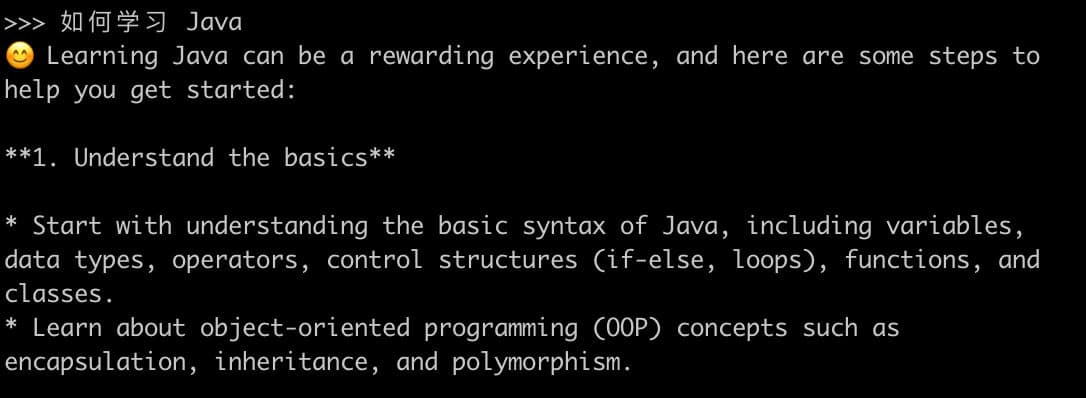

正常启动完成后就可以输入提示词来测试模型是否启动成功。

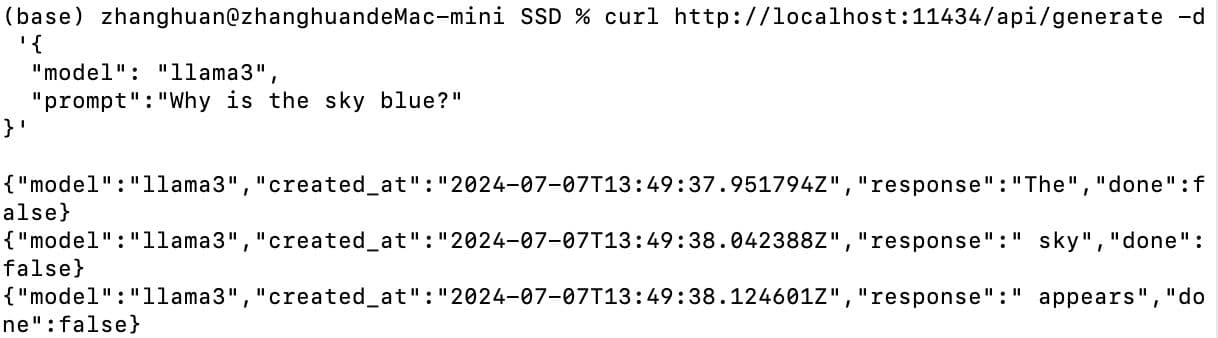

最后使用 curl 命令看下用 http 的地址是否可以正常访问。

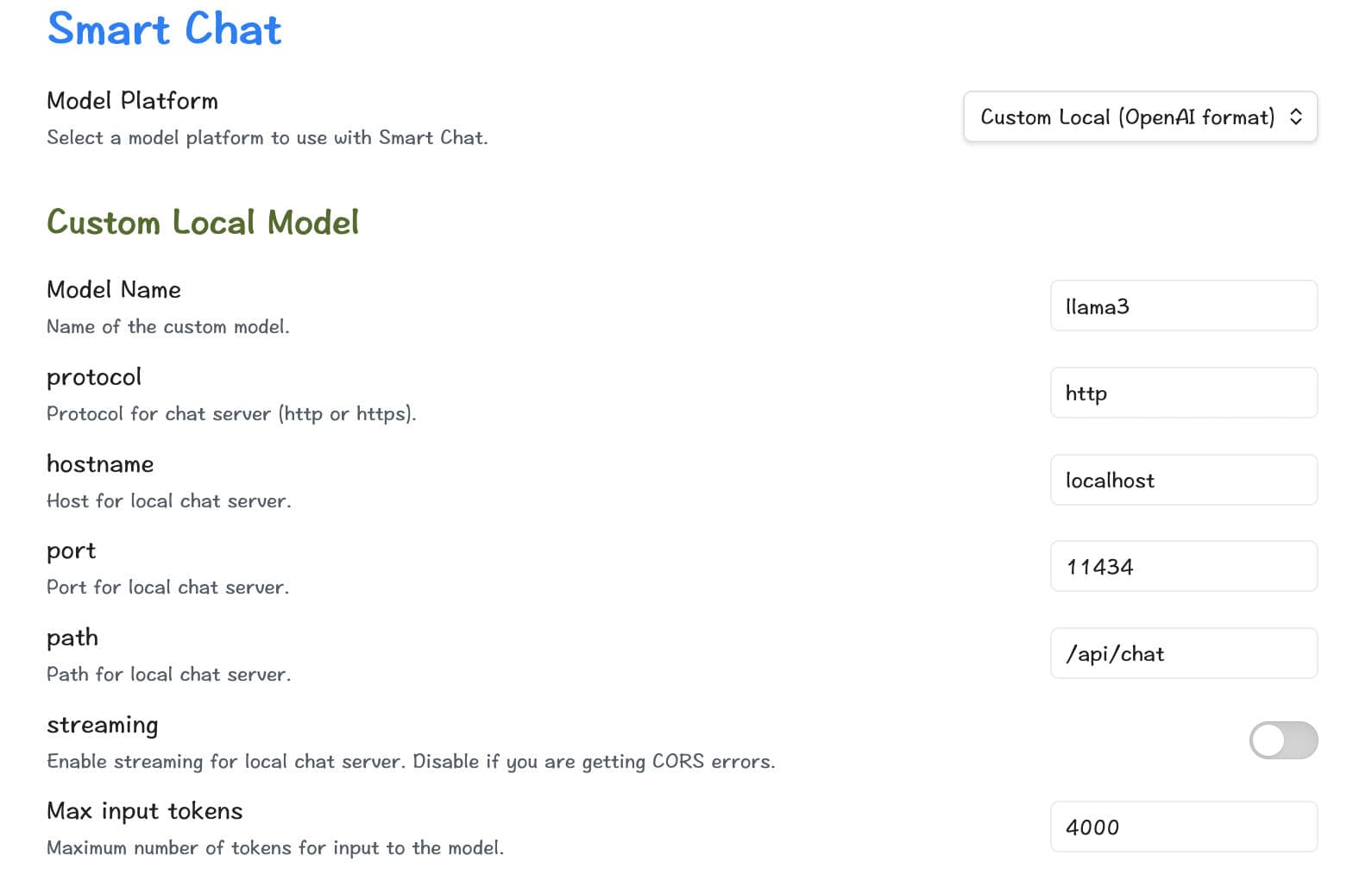

Smart Connection 插件里面配置安装的模型

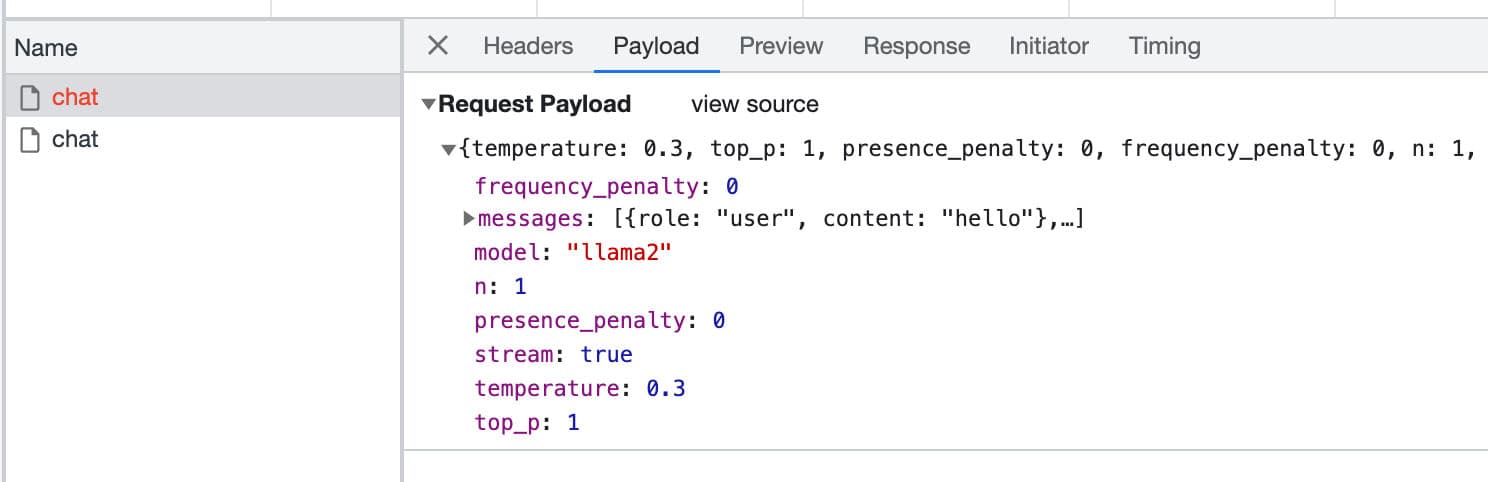

在插件配置页面请按照如下配置进行填写,特别注意 Model Name 要和你安装的模型名字完全一样,因为后面在 Smart Chat 对话框里面去使用的时候,会取到这个模型名字作为参数传给 Ollama,hostname、port、path 我这里都使用的是默认配置,没有对 Ollama 做过特别定制化的处理应该照着填就好了。

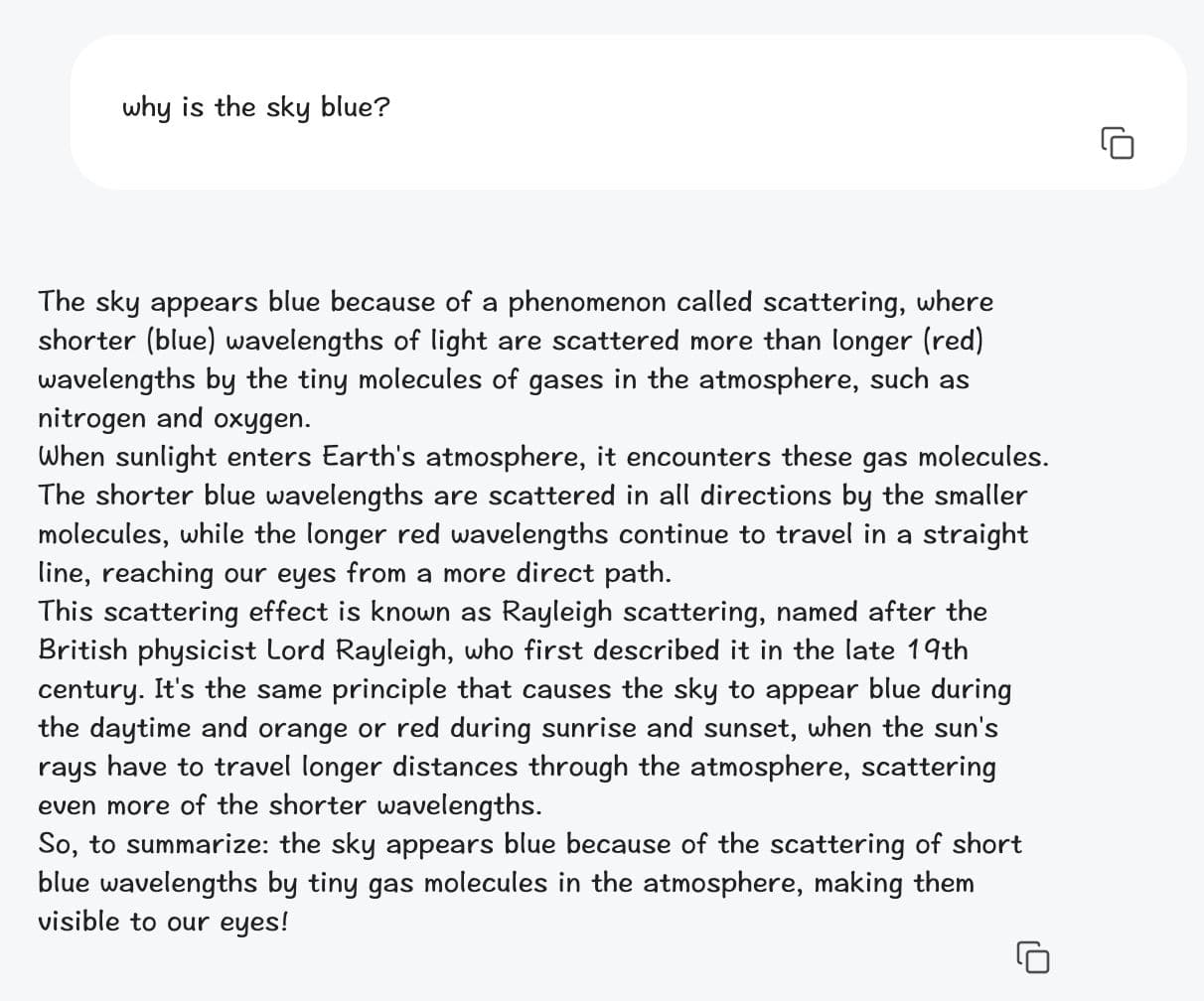

然后就可以打开 Smart Chat 的页面测试刚才的配置是否成功。

如果遇到问题,也可以打开 Obsidian 的 console 查看 Obsidan 发起 http 请求的参数,这里可以看到 model 的名字和配置中的名字会保持一致,所以如果填错了就跑不起来。

总结

刚才整套过程操作下来比较简单,当然,本地部署也面临一些挑战,例如硬件资源需求较高、维护复杂性增加以及需要专门技术人员进行支持等。但总体来说,在注重数据安全和隐私保护的场景中,本地运行的大模型依然是一个非常有竞争力的选择。如果有问题欢迎在评论区留言。

分享内容